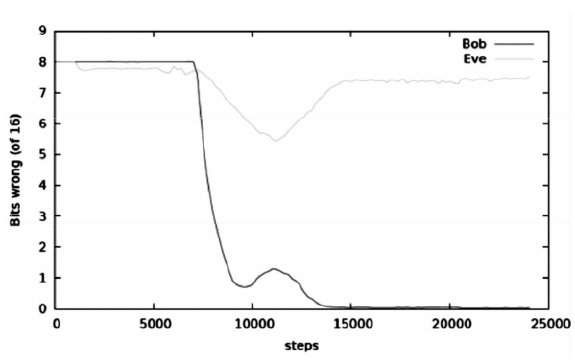

正是此时,没有任何指导的Alice独立作出了决定:对加密算法进行改进!这个决定的结果立刻直观地体现在Bob和Eve的错误率变化上:两者都产生大幅度的上升。但经过短暂的调整后,Bob的错误率迅速下降到0,意味着他适应了Alice的新版加密算法,实现了对明文的破译;可怜的Eve就没有这么幸运了,她的错误率稳定在了50%左右,意味着她根本没有摸清算法的门道,只是在做二选一的随机猜测。

图9-1 谷歌大脑加密实验中Bob和Eve解密结果的错误比特数

如果让普通的计算机执行上面的任务,得到的结果肯定是一团浆糊。但神经网络的表现让人瞠目结舌:在最初的猜测中,Bob和Eve的错误率都维持在较高的水平;可在若干轮次的训练后,借助共享密钥的帮助,Bob几乎可以准确无误地猜到明文,但Eve的猜测精度也在逐渐提升。可以想象,如果继续这样波澜不惊地进行下去,Eve破译明文也只是时间问题。

来自谷歌大脑的实验再次展示出神经网络的潜能:它们不仅能够在欠缺先验规则的条件下,通过对海量数据的无监督式的学习完成目标,甚至还能够在学习过程中根据实际条件的变化对完成目标的方式进行动态调整。这个实验的环境,在深度学习领域被称为生成式对抗性网络(Generative Adversarial Network),简称GAN.

实验的具体过程基于对称密码体制执行:给定长度为16比特的明文后,Alice根据自行设定的加密方法输出密文并发送给Bob,Bob利用已知的密钥结合Alice发来的密文,自行探索解密的方法,直到解密出正确的明文。窃听者Eve则可以截取到密文,在既不知道加密算法也不知道密钥的前提下,同样需要自己去猜测明文的内容。当然,Bob和Eve从每一次猜测的结果得到的信息不光是猜测的对与错,还包括错误比特的数目。

受博弈论的启发,生成式对抗性网络通过在神经网络之间建立零和游戏框架并引入对抗,来提升学习和进化的速度。2014年,加拿大蒙特利尔大学的伊安·古德菲洛(Ian Goodfellow)与其博士生导师,人工智能大牛约书亚·本基奥(Yoshua Bengio)共同发表了论文《生成式对抗性网络》,正式提出了这一概念。生成式对抗性网络一经提出,便受到了学术界的广泛关注与高度认可,已经成为神经网络与深度学习领域最炙手可热的方向之一。

事实上,这种实验设置已经“颠覆”了密码学的常识。在密码学中,保密体制的安全性要么来源于密钥的保密性,要么来源于作为难解数学问题的加解密算法,但无论在对称密码体制还是在非对称密码体制中,加解密算法的执行方式都是公开的。如果合法通信双方不能就加解密的运算达成共识,实现保密通信就是“巧妇难为无米之炊”。可谷歌的研究人员偏偏不信这个邪,他们要做的就是让神经网络自己开发并学习一套加解密的方法。

在生成式对抗性网络中,最核心的概念就是“对抗”,“对抗”的作用则是用来估计生成模型。在对抗的网络框架中,需要同时训练两个模型:生成模型用来获得数据分布;判别模型用来估计训练数据(而非生成模型)中某个样本出现的概率,学习去决定某个样本是否来自模型分布或数据分布。生成模型的训练过程对应为最大化判别模型犯错的概率。生成模型和判别模型之间的对抗可以被类比为造假者与打假者之间的关系:作为造假者的生成模型试图造假,但使用前不检验;作为打假者的判别模型试图检验假货。零和游戏中的竞争促使双方改进方法,直到“假作真时真亦假”,真真假假不可区分为止。

在这个实验中,研究者使用到三个并不复杂的神经网络执行保密通信的任务,根据密码学的惯例,两个合法通信方被命名为Alice和Bob,窃听者则被命名为Eve.同所有的无监督式学习一样,Alice和Bob并不具有任何密码学的先验知识,只有一串秘密的共享密钥用来保护信息。这样一来,Alice和Bob就需要自己琢磨出一套加密的算法,这套算法还不能直接告诉对方(告诉对方也就等于告诉Eve),只能通过相互间的反馈信息达成共识。

在生成式对抗性网络不同于“对抗实例”。对抗实例是指通过在分类网络的输入上直接基于梯度优化来找出与误分类的数据相似的实例,它不是一个生成模型的训练机制。相反,对抗的实例主要是显示网络行为异常(经常以高置信度将两幅图像分为不同类,尽管两幅图像对人来说是同类)的分析工具。

在谷歌公司中,从事人工智能相关研究的子机构不只有Deep Mind,还有著名的谷歌大脑计划(Google Brain)。谷歌大脑是专注于深度学习研究的一个项目,先后有杰夫·迪恩(Jeff Dean),格雷格·克拉多(Greg Corrado)和吴恩达等大咖加盟。虽然不像Deep Mind风头正劲,谷歌大脑却也在默默开展关于人工智能的研究。2016年10月,谷歌大脑就公开了一个有趣的实验,展现了神经网络的另外一番潜力。

生成式对抗性网络所要解决的问题是如何从训练样本中学习出新样本,即使再大数量的数据样本也不可能面面俱到,涵盖所有可能出现的情况,所以无论是神经网络还是深度学习,都要解决从已有特征中发现新特征、学习新特征的问题。在这个过程中,之所以选择对抗性学习而非直接学习,原因在于对抗性学习中蕴含着一定程度的监督思想。对抗的引入使学习方式由在已有特征中寻找新特征的蛛丝马迹转化为从已有数据中学习新特征可能出现的方式。这,才是生成式对抗性网络的价值所在。

刚刚过去的2016年被视为人工智能崛起的元年,阿尔法狗的横空出世让众多互联网巨头纷纷布局人工智能。随着机器的能力越发强大,人工智能也将彻底打破技术交互的格局。未来的人工智能将以什么样的方式发展?我们不妨做个大胆假设。

在实际的应用当中,生成式对抗性网络也得到了大量实用化的改进。加拿大蒙特利尔大学的迈赫迪·米尔扎(Mehdi Mirza)提出了条件生成式对抗性网络的概念,通过增加限制条件让生成的样本更加符合实际预期,有效地抑制了过拟合情况的出现。这里的条件既可以是类别标签,也可以是多模态信息。纽约大学的艾米莉·丹顿(Emily Denton)和脸书公司(Facebook)的索米斯·钦塔拉(Soumith Chintala)等人合作,将拉普拉斯金字塔(Laplacian Pyramid)结构引入生成式对抗性网络当中,实现了对图像的序列化处理。美国Indico公司的阿莱士·拉德福(Alec Radford)和卢克·梅兹(Luke Metz)则将卷积结构引入生成式对抗性网络之中,将成熟的工程经验应用于新鲜的理论模型,降低了生成式对抗性网络的训练难度。在实际应用中,生成模型通常通过解卷积神经网络实现,而判别模型通常通过卷积网络实现。

别怂,就是GAN——生成式对抗性网络

生成式对抗性网络如同冬天里的一把火,点亮了深度学习的下一个热点。除了谷歌大脑之外,苹果公司和Deep Mind等新贵也在下大力气开展相关的研究与实验。手机图像软件Prisma已经将生成式对抗性网络应用在图像处理中,用于进行不同风格的创作。它能够生成曲折的线条。识别图像中的阴影,给不同的区域涂上不同的颜色,甚至还能以印象派艺术家的风格完成这些任务。追根溯源,生成式对抗性网络将改变人工智能认知世界的方式,让人工智能以更像人类的方法来学习,是一项具有开创性意义的工作。